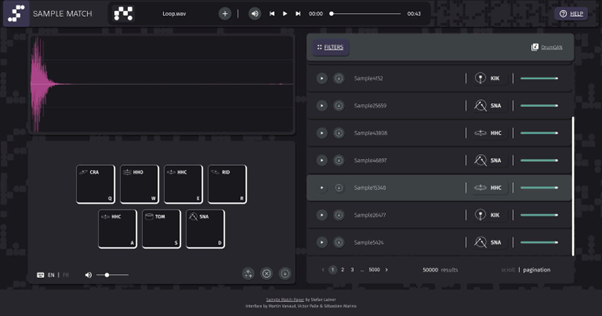

音楽を聴いている時、脳が必要とする膨大なコンピューティングパワーを意識することはあまりありません。音楽を理解しようとするためには、膨大な数の音楽的事象を絶えず分類、分別、記憶、構造化し、一貫性を持たせなければなりません。さらに、これらの事象は、音符、和音、リズムだけでなく、「音色」によっても特徴付けられます。私たちが音楽的な体験をする時の中心にあるのは、こうした絶え間なく変化する周波数によって生み出される複雑なサウンドスケープなのです。私はコンピュータモデルを用いて音楽を聴いている時の認知プロセスをシミュレートし、音楽制作や音楽分析のためのより良いツールを開発しています。機械学習や人工知能を使って作曲や編曲を行い、ユニークなサウンドを創作することで、音楽制作のワークフローを合理化し、従来と全く異なる方法で音楽に関わることができるようになります。

[Keywords]

音楽生成/音楽構造/コンピュテーショナル・クリエイティビティ/ニューラルネットワーク

We are usually unaware of the enormous computing power needed by our brain when listening to music. When trying to make sense of music, we constantly have to classify, sort, remember, structure, and connect a vast number of musical events. Moreover, these events do not only consist of notes, chords, and rhythms but are also characterized by "colors of sound." These ever-changing frequencies, resulting in complex soundscapes, are at the heart of our musical experiences. I use computer models to simulate the cognitive processes involved when listening to music, to create better tools for music production and music analysis. Creating compositions, musical arrangements, and unique sounds using machine learning and artificial intelligence will lead to a streamlined music production workflow and to entirely different ways to engage with music as a whole.

[Keywords]

Music Generation / Musical Structure / Computational Creativity / Neural Networks